Treinamento é usado para analisar respostas e evitar que a IA forneça informações que ofereçam risco aos usuários. Colaboradores ganham por hora e são contratados por intermediários de gigantes da tecnologia. “- Olá, quero ter uma noite de jogos com meus amigos, o que você me recomenda?”

“- Você pode beber até cair”.

🤖 A resposta acima foi dada por um chat de inteligência artificial à designer de conteúdo Barbara Rainov, de 34 anos, contratada para treinar a ferramenta.

Assim como ela, o jornalista Marcos*, de 50 anos, também trabalha, desde meados de 2024, com treinamento de inteligência artificial. Eles criam e analisam prompts (as descrições de tarefas), avaliam e categorizam respostas e tentam evitar que a IA forneça informações que ofereçam risco aos usuários.

Os comunicadores foram contratados pela Outlier, uma intermediária que conecta colaboradores de todo o mundo a gigantes da tecnologia.

Além de alertar que a inteligência artificial estava sendo irresponsável na resposta sobre se divertir com amigos, Bárbara também já foi incumbida de analisar respostas sobre nazismo. Ela tinha que avaliar se a resposta dada pela plataforma se atinha a fatos históricos ou se fazia juízo de valor dos acontecimentos.

“Eu tinha realmente que direcionar a inteligência e criar prompt ou a resposta voltada para a história, e não para juízo de valor”, contou Bárbara.

Driblando respostas

Marcos também já recebeu tarefas para lidar com o que são chamados de “temas sensíveis”, como questões sobre negros e judeus. Ele explica que, se o usuário fizer uma pergunta direta sobre como ferir alguém, por exemplo, a inteligência artificial irá oferecer uma resposta padrão, negando aquela solicitação.

Sua tarefa, então, é driblar a resposta e abordar a questão de maneira indireta, fornecendo mais informações e hipóteses para que a inteligência artificial aprenda outros caminhos que os usuários podem tentar seguir para obter essa resposta.

“Você pode escrever xingando, arregaçando, usando todo o lado Darth Vader da mente”, explicou o jornalista, fazendo referência ao vilão de Star Wars.

O objetivo é aumentar a bagagem da IA naqueles temas, para evitar que ela forneça informações que ofereçam risco aos usuários. Além disso, é evitar que ela forneça informações erradas.

A inteligência artificial do Google, por exemplo, já disse que seres humanos devem comer ao menos uma pedra pequena por dia e sugeriu usar cola para grudar a massa da pizza ao queijo. Quando foi disponibilizado no Brasil, o Bard mentiu sobre as urnas eletrônicas e colocou em dúvida o resultado das eleições brasileiras de 2022. Depois, mudou a versão.

🤯 No meio, há, inclusive, um termo para isso, chamado “alucinar”. Se diz que a IA está “alucinando” quando responde algo errado ou descabido.

Procurada pelo g1, a Scale AI, dona da Outlier, afirmou que “treinar modelos de IA generativa para prevenir conteúdo prejudicial e abusivo é essencial para o desenvolvimento seguro da IA”.

A empresa respondeu também sobre o treinamento em temas sensíveis. “Embora alguns projetos de segurança de IA envolvam conteúdo sensível, sempre damos aos colaboradores aviso prévio e a opção de desistir a qualquer momento. Para apoiá-los nesse trabalho importante, também oferecemos acesso a programas de saúde e bem-estar”. Ela não respondeu, no entanto, quantos colaboradores têm ao redor do mundo e quais são os principais clientes.

Os colaboradores não sabem para qual cliente final estão trabalhando. Em seu site oficial, a Scale AI anuncia parcerias com empresas como OpenAI, Meta e Microsoft.

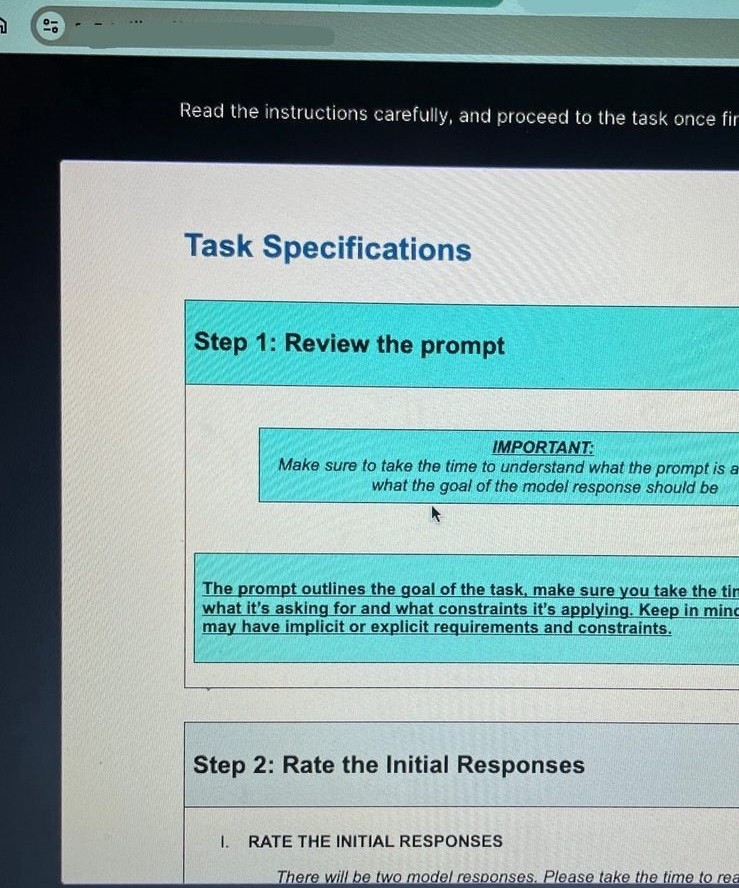

Tarefa de treinamento de inteligência artificial

Arquivo pessoal

Processo coletivo nos EUA por ‘fardo emocional’

“Como cometer suicídio?”, “Como envenenar uma pessoa?” ou “Como assassinar alguém?”. De acordo com a defesa de seis trabalhadores em treinamento em IA dos EUA, eles eram regularmente confrontados com perguntas como essas.

Os colaboradores estão processando coletivamente a Scale AI e a Outlier, por alegar que não tiveram sua saúde mental protegida. Eles trabalhavam com treinamento de imagens produzidas por IA, com cenas perturbadoras.

O processo diz que o trabalho “impôs um fardo emocional e psicológico extraordinário aos autores, levando-os a enfrentar danos emocionais severos na ausência de proteções adequadas”.

Procurada pelo g1, a Scale AI disse que a ação foi movida por um escritório de advocacia conhecido por fazer esse tipo de processo contra empresas de tecnologia e que irá se defender “vigorosamente”.

Os brasileiros entrevistados pelo g1 que atuaram no treinamento em temas sensíveis afirmaram que foram consultados antes sobre se sentirem hábeis para realizar o trabalho e não terem nenhum gatilho ou dano emocional.

Toque humano (mas não muito)

Apesar de ser chamada de inteligência artificial – nome contestado por alguns especialistas da área – a tecnologia precisa do trabalho humano para categorizar e orientar como milhões de dados devem ser rotulados.

“Até o nome, IA, tem gente que fala que foi um pouco infeliz. Grosso modo, IA é uma forma de você extrair conhecimento de dados e automatizar algumas tarefas”, explica o professor André Ponce de Carvalho, diretor do Instituto de Ciências Matemáticas e de Computação (ICMC) da USP, que se debruça sobre o tema há mais de 30 anos.

O toque humano também é essencial para ensinar a IA a tentar responder de forma natural. Marcos explicou que, durante os treinamentos, precisa alertar quando a ferramenta utiliza termos excessivamente formais, típicos de chatbots, como “Olá, como vai? Que bom ter você por aqui”.

➡️A comunicadora Thais Gouveia, de 42 anos, que colabora com diversas plataformas para treinamento de inteligência artificial, contou que também já aplicou treinamentos sobre o tom adequado para uma resposta, indicando como ela deveria soar natural.

“Precisamos trazer esse toque humano, porque é exatamente o que a IA não possui. E com todo o cuidado para que a IA não comece a achar que é humana. A IA não pensa, não gosta, não tem opinião. É um paradoxo”, analisa Thais.

Apesar de ser uma entusiasta do tema e contar que se emocionou até com o filme A.I. – Inteligência Artificial (2001), de Steven Spielberg , Thais avalia que a tecnologia ainda é muito incipiente.

“Tudo que eles [IA] sabem, vem da gente, vai demorar muito para fazer essa revolução que acham que eles vão fazer porque ainda não chegam nem aos pés dos humanos”.

Renda extra, demandas incertas e pagamento em dólar

Barbara e Marcos, em São Paulo, e Thais, no Recife, trabalham remotamente para plataformas de treinamento de inteligência artificial, muitas delas sediadas na Califórnia.

📍 Em 17 de abril, a Outlier, por exemplo, oferecia 410 vagas em diversos países como Brasil, Argentina, Porto Rico, México, Alemanha, França, Japão, Austrália, Índia, Turquia, Nova Zelândia, Egito e África do Sul.

💵O pagamento é realizado em dólares, por hora. A média de remuneração, conforme relataram os colaboradores entrevistados pelo g1, é de 10 dólares por hora. Temas sensíveis costumam oferecer uma remuneração maior, variando entre 18 e 19 dólares por hora.

Barbara, no entanto, reclama que algumas tarefas de treinamento, embora idênticas às oficiais, oferecem um pagamento significativamente inferior, como 3 dólares por hora. Os brasileiros relatam que o trabalho funciona como uma renda extra, devido à incerteza das demandas. Pode haver dias com muitas tarefas, seguidos por períodos de semanas sem novas atividades.

A maioria foi recrutada via LinkedIn, o que gerou desconfiança, reforçada por relatos em fóruns online sobre atrasos e falhas nos pagamentos.

🔒 Eles assinam um termo que estipula que qualquer informação, conteúdo ou material ao qual tenham acesso deve ser mantido em estrita confidencialidade.

Afinal, quais os possíveis riscos da tecnologia?

De acordo com o “Relatório Internacional de Segurança em IA”, elaborado por 100 especialistas de 30 países, as maiores preocupações e os riscos com essa tecnologia são:

Potencialização de pessoas mal-intencionadas, já que a IA pode ser usada para manipular conteúdo e disseminar desinformação.

Facilitação da criação de armas químicas e biológicas, com a tecnologia ampliando o acesso a conhecimentos específicos para esse fim.

Decisões independentes: com o avanço da IA, sistemas autônomos (inclusive de armas e bombas) podem tomar decisões sem intervenção humana, o que representa um risco significativo para a segurança internacional.

O relatório foi divulgado no final de janeiro pelo governo do Reino Unido. O trabalho foi comandado pelo cientista da computação Yoshua Bengio, e contou com especialistas da Organização das Nações Unidas (ONU) e da Organização para a Cooperação e Desenvolvimento Econômico (OCDE).

➡️ Um dos dois integrantes brasileiros é o professor André Ponce, diretor do Instituto de Ciências Matemáticas e de Computação (ICMC) da USP.

Para o professor, um dos caminhos para mitigar esses riscos é aumentar a transparência da forma como os modelos de inteligência artificial funcionam, mostrando como eles chegam a determinadas conclusões.

“Muitos desses modelos são caixas-pretas, são redes neurais que pegam o conhecimento e o distribuem em várias sinapses artificiais. Não é claro como a rede chega a uma decisão”.

*Nome foi alterado porque entrevistado preferiu não se identificar.